识别人类情绪、实时回答更健谈!GPT-4o发布或开启人工智能交互新潮流

OpenAI又迎来升级,摇身一变成了人工智能语音助手。

北京时间周二凌晨1点, 人工智能(AI)巨头OpenAI举行春季发布会。公司首席技术官Mira Murati带来了多项与ChatGPT有关的更新。

本次发布会要点:

新的 GPT-4o 模型:打通任何文本、音频和图像的输入,相互之间可以直接生成,无需中间转换

GPT-4o 语音延迟大幅降低,能在 232 毫秒内回应音频输入,平均为 320 毫秒,这与对话中人类的响应时间相似。

GPT-4o 向所有用户免费开放

GPT-4o API,比 GPT 4-Turbo 快 2 倍,价格便宜 50%

惊艳的实时语音助手演示:对话更像人、能实时翻译,识别表情,可以通过摄像头识别画面写代码分析图表

ChatGPT 新 UI,更简洁

一个新的 ChatGPT 桌面应用程序,适用于 macOS,Windows 版本今年晚些时候推出

整场发布会中,最吸引人的莫过于GPT-4o 模型。

据OpenAI表示,GPT-4o是一个“原生多模态”模型,它的命名来源于“omni”,即包罗万象之意。

比起此前要么是图文模式要么是语音模式的GPT-4,它更擅长打组合拳,可以接受文字、音频、图像的任意组合输入,然后无缝衔接图文音频的多种形式输出。

GPT4o可检测人的情绪

OpenAI联合创始人奥特曼曾表示,“多模态交互能力非常强大,比如可以问:‘嘿,ChatGPT,我正在看什么’或‘我不太确定这是哪种植物。’”

“我期望的是一种始终处于激活状态,且极易使用的设备,可以通过语音、文字,或者更理想的其他状态,来理解我的需求。”奥特曼表示,“设想有个系统能全天辅助我,尽可能多地去收集上下文信息,成为世界上最出色的助理,不断地帮助我提升自我。”

通过响应速度的大幅提升,该模型在语音模式下,已经可以达到“实时”响应的状态,不再需要尴尬地等上几秒钟,等ChatGPT给出一个回答。

换句话说,用户可以与ChatGPT像真人一样聊天——在机器人回应的过程中打断它,提出更多的要求(例如转变话题、要求机器人改变语音语调),再也不需要等待机器人完成上一个问题的回复后,再提出新的问题。

发布会上,主持人与ChatGPT寒暄几句,它能够从对方的喘气声中理解“紧张”的含义,并且指导他进行深呼吸。

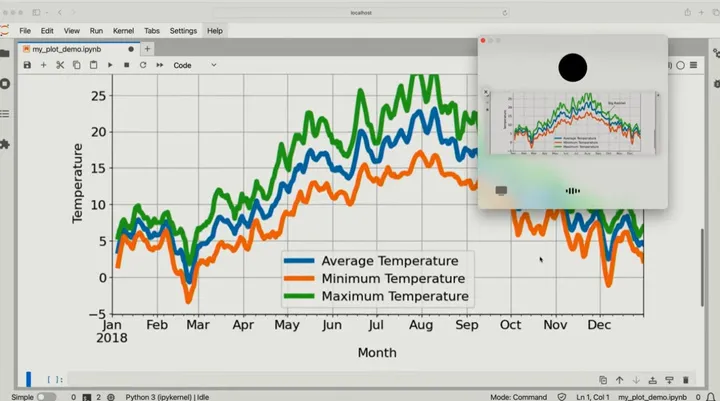

随后,主持人开了摄像头,拍了白纸上一道题目,请ChatGPT实时帮忙解一个一元方程题,又解读了一幅气温图表。除了图像识别和解题能力外,ChatGPT展现了实时根据影像变化,与人们实时互动的能力。

主持人还展示了和ChatGPT进行意大利语、英语的对话聊天,ChatGPT毫不费力地就能充当两人的现场翻译员,实时准确地翻译出对话内容。

用户无需注册即可使用ChatGPT

此外,OpenAI宣布,将允许用户直接使用ChatGPT,而无需注册该项服务,同时ChatGPT的免费用户也能用上最新发布的GPT-4o模型(更新前只能使用GPT-3.5),来进行数据分析、图像分析、互联网搜索、访问应用商店等操作。这也意味着GPT应用商店的开发者,将面对海量的新增用户。

当然,付费用户将会获得更高的消息限制,至少是免费用户的5倍。当免费用户用完消息数量后,ChatGPT将自动切换到 GPT-3.5。另外,OpenAI将在未来1个月左右向Plus用户推出基于GPT-4o改进的语音体验,目前GPT-4o的API并不包含语音功能。

苹果用户迎来ChatGPT桌面应用

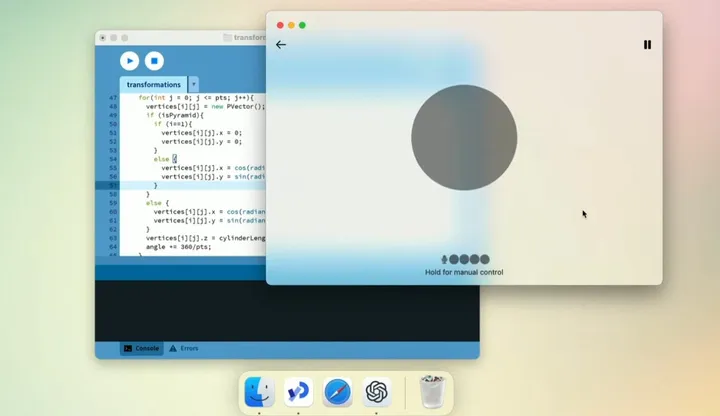

最后,苹果电脑用户将迎来一款为macOS设计的ChatGPT桌面应用,用户可以通过快捷键“拍摄”桌面并向ChatGP提问,OpenAI表示,Windows版本将在今年晚些时候推出。

OpenAI 还表示,ChatGPT 还优化了用户界面,有了全新的界面。OpenAI 的演示显示,用户可以将处于最小化窗口的 ChatGPT 桌面应用与其他程序并排打开。用户可以通过输入或语音的方式向 ChatGPT 提问屏幕上显示的内容,ChatGPT 则能根据其“所见” 进行回答。

对于苹果用户,人们可以通过 Option + 空格键向 ChatGPT 提问,并且可以在应用内截取和讨论屏幕截图。

参考来源:潮新闻客户端、机器之心、果壳、GitHub爱好者社区等

整理:段大卫

北京科技报微信

北京科技报微信

北京科技报客户端

北京科技报客户端